Représentations efficaces de l'apparence

sous-pixel

Sujet de thèse 2014-2017

Candidat: Guillaume LOUBET

Encadrant: Fabrice

NEYRET ( HDR, DR CNRS, Maverick - LJK / INRIA )

Les domaines du graphique temps-réel comme du rendu off-line butent

sévèrement sur le mur de la complexité quantitative: Les mondes trop

vastes et détaillés non seulement n'entrent plus dans les machines

(leur poids s'accroît beaucoup plus vite que la loi de Moore),

mais en plus finissent par engendrer une moindre qualité visuelle (car

traiter exhaustivement tout ce qui se projette dans chaque pixel

pendant chaque intervalle de temps n'est pas raisonnable),

alors même que seule une infime portion de l'information apparaîtra

au final a l'écran.

Il faudrait être capable de pré-filtrer les données. Le problème est

que les hypothèses historiques du graphique sont aujourd'hui à peu

près toutes caduques (les détails sont sous-pixel, les

propriétés sont corrélées, les phénomènes optiques considérés sont

complexes, et les exigences de qualité bien plus grande qu'aux

temps héroïques, bref rien n'est linéaire ni séparable ni

homogène), mais que le domaine n'arrive guère à dépasser

ce paradigme, et se trouve coincé entre surcoût de multi-sampling

et artefacts visuels (aliasing et dérives lors du zoom).

Notre équipe s'attache à proposer des solutions à la fois efficaces

et haute-qualité, et surtout, scalables, en concevant des

représentations et algorithmes modélisant l'apparence émergeant à

l'échelle du pixel des effets cumulés des détails à petite échelle.

Le cône collectant les contributions d'un pixel traverse la scène à

une résolution volumique égale à son diamètre, il s'agit donc de

savoir décrire le comportement optique de la matière à l'échelle

d'un élément de volume rencontré, sans différence perceptible avec

l'image à meilleure résolution qu'on obtiendrait lors d'un zoom.

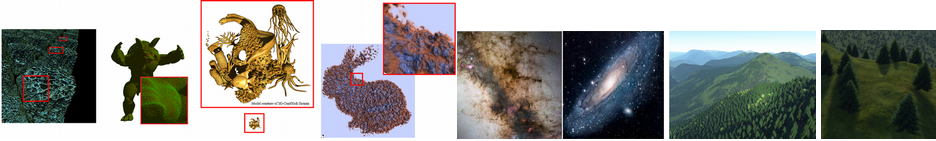

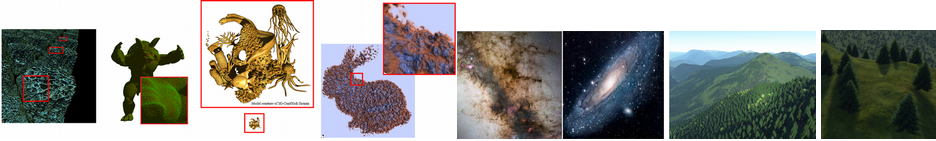

Nos travaux précédents sur le sujet ont concerné soit des "matériaux

volumiques" extrêmement typés, comme les

arbres ou les vagues, soit des matériaux très génériques mais

limité à la classe des champs de

hauteur sur objets opaques, soit à l'environnement de cone-tracing

volumique scalable (GigaVoxels) mais ne gérant pas le filtrage

lui-même.

Il s'agit maintenant de s'attaquer au coeur du sujet: le filtrage

de l'apparence volumique, au moins pour quelques classes de

matériaux bien choisies, permettant d'enfin pouvoir préfiltrer les

scènes du domaine graphique, dans des situations de complexité

croissante (ne serait-ce qu'en terme d'échelle de filtrage, du

proche à l'ultime), permettant de faire sauter progressivement le

verrou technologique.

On privilégiera deux approches - nullement incompatibles - : la

dérivation de méthodes de filtrage de l'apparence de données

3D existantes (explicites ou statistiques), via l'introduction de

descripteurs et d'hypothèses avec un bon compromis

tractabilité/généralité, et la conception de modèles descriptifs de

distribution volumique se prêtant par construction mieux au

filtrage, voire permettant d'adopter un procédé de modélisation

top-down alternatif aux procédés actuels (maillages et fonctions

procédurales).

Même si le coeur de recherche n'est pas le transfert radiatif, dans

les deux cas le critère de qualité est l'apparence en espace image,

en tenant compte de la visibilité, de l'ombrage, et des propriétés

optiques élémentaires (réflectance, couleur, voire texture).

Même si le temps-réel n'est pas le seul débouché et si l'animation

est hors cadre, on s'appliquera à préserver la compatibilité des

représentations et algorithmes aux contextes temps-réel et animés.

Côté applications et collaborations, notre ANR Galaxy/VeRTIGE sur

l'exploration réaliste de galaxie (avec RSA Cosmos et l'Observatoire

de Meudon), et Weta Digital avec qui nous collaborons sur ces

sujets, sont directement intéressées, cependant le sujet s'attaque à

un problème de fond pour lequel il est important de proposer des

pistes d'applicabilité large.

--

Fabrice